智东西(公众号:zhidxcom)

文 | 海中天

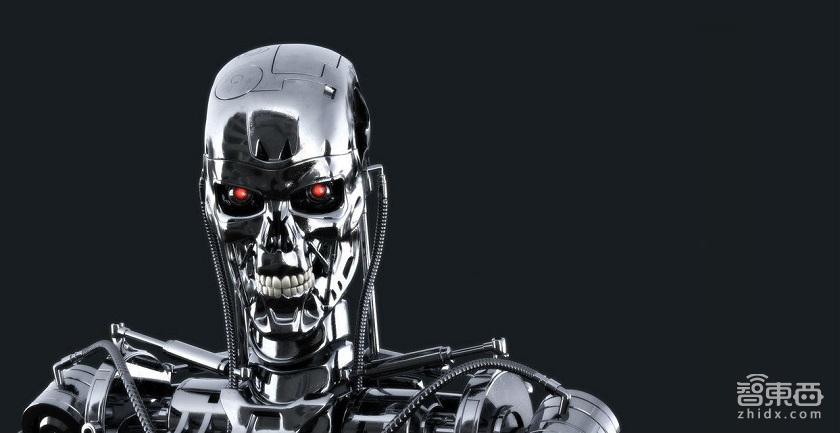

在战争中,让士兵远离伤害是有意义的事。想想古代的加农炮和来复枪,到现代的巡航导航和无人机。越往后,人类会越依赖电脑来作决策。这种趋势意味着未来会出现完全自主攻击的武器:一个机器人系统,它可以选择并攻击目标,甚至包括攻击人类,不需要人类的监督。

问题在于部署此类机器人真的符合伦理吗?最近美国的无人机项目遭曝光,我们已经开始对机器人武器有所担忧了。理论上看,越来越多的自主武器将变得更敏捷更精准。

不久前,我有机会与三位伦理哲学家讨论自动武器的道理问题,这些争论已经被我纪录下来。

先介绍一下三人的身份:

纽约大学助理教授和教员邓肯士·普尔夫斯(Duncan Purves),加州州立理工大学哲学助理教授雷恩·詹金斯(Ryan Jenkins),美国海军研究生院(Naval Postgraduate School)哲学助理教授、牛津大学武装冲突中心伦理和法律助理研究员布拉德利·J·斯拉斯威(Bradley J. Strawser)。

下面是具体讨论的问题:

问:什么是自主武器?

答:我们谈论的是自己能作决定的武器,尤其是指作出破坏或者可能存在破坏的决定。你可以想像一下,一件武器——比如无人机——看到人类然后说:“那是一个人”,然后它认定看到不只是一个人,而且还是一个士兵,而且士兵还是敌对行动中敌方的一部分,而且还是攻击目标。接着最令人担心的事情发生了,机器人决定使用武力攻击人类。

有一点很重要,那就是整个事情没有人在背后操纵,没有人将手指按在扳机上。一旦我们部署这样的武器,攻击谁、谁是敌人完全由它自己决定。

问:这点确实让人担心,我们离自主武器到底有多远呢?

答:要让机器达到这种程度,我们当然还面临许多挑战。我们都知道机器作决策的速度比人类快几万倍,我们也知道技术的发展是很快的。正因如此,各国军队才会纷纷提高自动化水平。

现在我们已经有几件武器可以执行自主攻击功能,例如,巡航导弹可以选择自己的路线和攻击目标,它还可以根据侦测的目标自主决定爆炸力。

提高武器的自主能力有很多好处:它可以更好地处理信息,加快战斗节奏,更重要的是保护士兵免受伤害。

有许多团队反对自主武器,最著名的可能是“停止杀手机器人运动”组织,它主要由哲学家、律师、士兵组成。

问:反对杀手机器人,人们的主要论点是什么?

答:一些人认为不论我们的技术多么进步,机器永远无法履行士兵的义务,它们永远无法权衡和领会下决心夺走一条生命意味着什么。这是反对自主武器的一个重要观点:机器人不能权衡和感知自己所作决定带来的破坏力。如果它们不能做到这点,就不应该采用。

还有一个比较流行的争论点,那就是机器人一旦可以做一些带来麻烦的事,将无人被追究责任。没有人会受到惩罚,没有人会上军事法庭。不负责任既是对敌人的不尊重,也是对战争法则的的不尊重,它将无视国际法就挑起战事。

问:这些争论有什么错误的地方?

答:从表面上看,我们认为这样的争论关心的是偶然事件:它们之所以发生是因为当前的技术还不成熟。你可以想像一下完美的自主武器:它从不犯错,总是杀正确的敌人,总是将伤害降到最低,只求达成目标即可。这样的机器人部署到现实中有什么错?它犯错的确没有人负责,但它从不犯错,谁会关心?

问:你们的观点有何不同?

答:我们主要有两个争论点。第一点,许多哲学家相信道德无法融入到一系列指令中。行为道德很复杂,它依赖经验、实践和对细节的把握,它还需要其它一些东西,如判断、直觉和道德感,这些都是难以用文字表述的。如果这样的观点是正确的,那么我们就无法真正在一系列指令中融入道德感,也无法用这样的指令打造完美的自主武器。

问:电脑不能自己通过学习变得完美吗?机器不能学习那些可靠的人,包括他们符合道德的行为吗?

答:是的,正因如此我们才有第二个争论点。也就是说无论机器变得多么精巧复杂,它都永远不能像人一样根据“正确的原因”采取行动。

问:为什么根据正确的原因行动如此重要呢?

答:首先,从直觉上看它很重要。一个人送花给自己迷恋的人,为的是能亲近她;一个人送花给自己迷恋的人,为的是激怒她的男朋友:二者之间是完全不同的。不同之处在前者有正确的原因,后者则原因错误。另外,如果机器无法根据正确的原因行动而我们仍然可以使用它,我们就应该可以允许那些心理不正常但表现很乖的人当兵。现在大多的人已经知道,将行为表现很好的心理不正常者放在军队中会带来很严重的问题。因为人道主义干预而发动战争和因为争夺资源而发动战争是完全不同的,尽管从表像来看是一样的。

问:我们所有讨论的要点是什么?

答:我们最后考虑一种可能,即未来的机器人在作出符合道德的重要决定方面比人类好很多。假设机器人成了道德的信徒,到时我们是不是应该将所有困难的决策全部交给机器处理?它们不只决定战争的目标是谁,还决定是否应该开战,决定谁是盟友,决定哪些地方应该占领等等。总之,它们应该能比我们更好地作决策,知道如何做对我们有利,对世界有利。如果他们在决策上做得很好,我们是不是应该将我们的自主权交给机器?